VSA: Mejorando la Atención en Transformadores de Visión con Ventanas Adaptativas

Fuente original: VSA - Ventanas de Tamaño Variado

Los modelos de Transformers de Visión (ViTs) han revolucionado el procesamiento de imágenes, pero aún enfrentan desafíos clave en la gestión de dependencias espaciales. Tradicionalmente, estos modelos utilizan ventanas de atención de tamaño fijo, lo que limita su capacidad para adaptarse a objetos de distintos tamaños y modelar relaciones a largo plazo. Para solucionar esto, se introduce VSA (Variable-Size Attention), un nuevo mecanismo que permite ajustar dinámicamente el tamaño de las ventanas de atención.

🔍¿Qué es VSA?

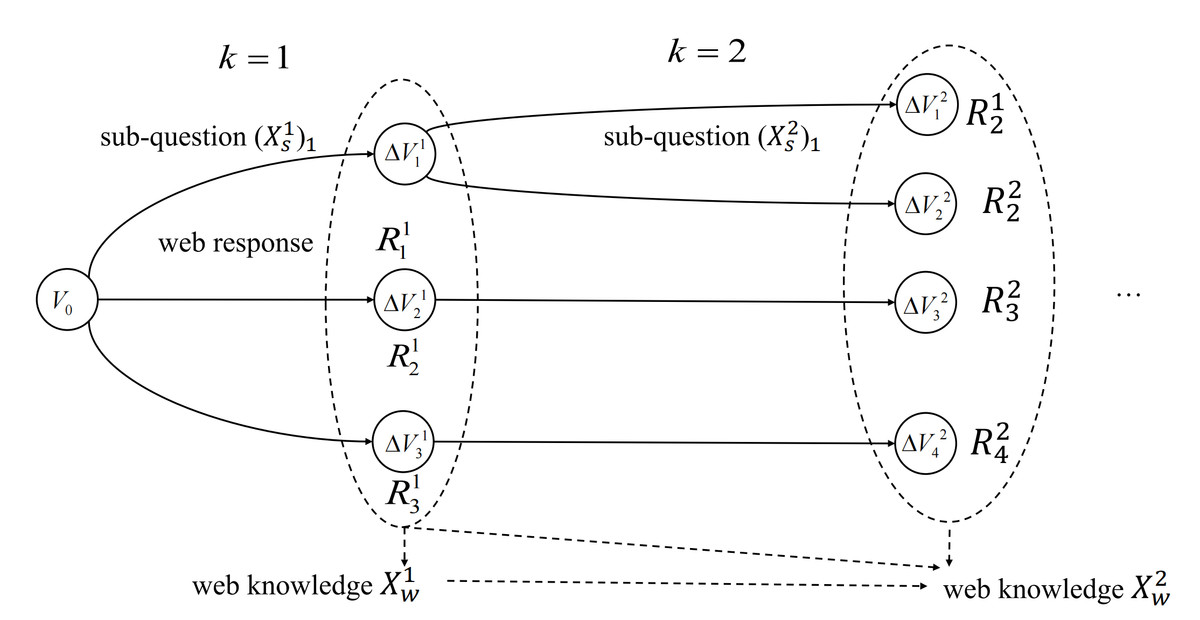

VSA es una técnica innovadora que aprende dinámicamente las configuraciones de las ventanas de atención, optimizando el área sobre la cual el modelo pone su enfoque. En lugar de trabajar con un tamaño predefinido, VSA predice el tamaño y la ubicación óptimos de la ventana de atención en función de la imagen de entrada.

🛠️¿Cómo funciona?

- Regresión de Ventanas:Un módulo de regresión predice el tamaño y la ubicación de las ventanas en cada capa de atención.

- Atención Adaptativa:Cada cabeza de atención ajusta sus ventanas de manera independiente, lo que permite capturar tanto detalles locales como dependencias globales en la imagen.

- Superposición de Ventanas:Al compartir información entre ventanas superpuestas, el modelo mejora la representación contextual sin aumentar significativamente el costo computacional.

🚀 Beneficios de VSA

✅ Mejora el rendimiento: Implementar VSA en arquitecturas existentes como Swin Transformer ha demostrado mejoras significativas en tareas de clasificación de imágenes. En ImageNet, el modelo Swin-T con VSA logró un aumento del 1.1% en precisión.

✅ Más adaptable: Puede manejar imágenes de diferentes escalas, mejorando la detección de objetos de tamaños variados.

✅ Eficiencia computacional: Se puede integrar en modelos existentes con modificaciones mínimas y sin un impacto significativo en el costo computacional.

🖼️ Aplicaciones de VSA

VSA no solo mejora la clasificación de imágenes, sino que también tiene aplicaciones en:

🔹 Detección de Objetos

🔹 Segmentación de Imágenes

🔹 Reconocimiento de Patrones Complejos

📂 Código y Recursos

El código fuente y más detalles sobre VSA están disponibles en GitHub para aquellos interesados en implementarlo o experimentar con su potencial.

Conclusión:

VSA representa un paso adelante en la evolución de los Transformers de Visión, permitiendo una mayor flexibilidad y precisión en la interpretación de imágenes. Al aprender dinámicamente el tamaño de las ventanas de atención, esta técnica resuelve una de las principales limitaciones de los ViTs actuales y allana el camino para modelos más eficientes y precisos en el futuro.

📌 Fuente original: VSA - Ventanas de Tamaño Variado